Здравствуйте, гость ( Вход | Регистрация )

24.06.2013 - 14:04 24.06.2013 - 14:04

Сообщение

#1

|

|

|

Группа: Пользователи Сообщений: 68 Регистрация: 21.01.2012 Пользователь №: 23436 |

Должность (категориальная величина) - Зарплата (количественная; руб):

вахтёр - 10 000 завхоз - 25 000 инженер - 20 000 директор - 300 000 Каким МЕТОДОМ показать, что зарплата директора отличается от других статзначимо?  English is my hobby.

|

|

|

|

|

|

Ответов

26.06.2013 - 18:50 26.06.2013 - 18:50

Сообщение

#2

|

|||

|

Группа: Пользователи Сообщений: 116 Регистрация: 20.02.2011 Пользователь №: 23251 |

Интересная тема развивается

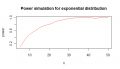

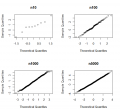

1. Я считаю, что проверять отклонение от нормальности распределения данных с помощью тестов на нормальность распределения при экстремально маленьких выборках не имеет особого смысла, поскольку эти тесты не обладают достаточной мощностью при таких размерах выборки, чтобы идентифицировать эти самые отклонения от нормальности. Так, например, тест Шапиро-Уилка не способен отличить распределение Гаусса, Пуассона, равномерное распределение при размере выборки в 6 наблюдений (что говорить про 3?): CODE shapiro.test(rnorm(6)) # нормальное распределение shapiro.test(rpois(6,4)) # Пуассона shapiro.test(runif(6,1,10)) # Равномерное shapiro.test(rexp(6,2)) # экспоненциальное shapiro.test(rlnorm(6)) # лог-нормальное Только лишь в последнем случае половина значений меньше 0,05. Существуют определенные расчеты, что минимальный размер выборки для теста Kolmogorov-Smirnov - 5 и более наблюдений, для Shapiro-Wilk - 7 и более, для D'Agnostino - 8 и более наблюдений. Если мы хотим узнать минимальный размер выборки для теста Шапиро-Уилка с определенной мощностью, можно написать следующее: CODE results <- sapply(5:50,function(i){ p.value <- replicate(100,{ y <- rexp(i,2) shapiro.test(y)$p.value }) pow <- sum(p.value < 0.05)/100 c(i,pow) }) и затем построить график: CODE plot(lowess(results[2,]~results[1,],f=1/6),type="l",col="red", main="Power simulation for exponential distribution", xlab="n", ylab="power" ) По графику можно определить, что для того, чтобы отличть экспоненциальное распределение от нормального с мощностью 80%, нужно около 20 наблюдений. 2. По-моему, определять нормальность распеделения с помощью тестов на нормальность распределения при больших выборках не имеет смысла, поскольку даже минимальные отклонения от идеального Гауссовского распределения будут приводить к статистически значимым отличиям. CODE x <- replicate(100,{ c( shapiro.test(rnorm(10)+c(1,0,2,0,1))$p.value, shapiro.test(rnorm(100)+c(1,0,2,0,1))$p.value, shapiro.test(rnorm(1000)+c(1,0,2,0,1))$p.value, shapiro.test(rnorm(5000)+c(1,0,2,0,1))$p.value ) } ) rownames(x)<-c("n10","n100","n1000","n5000") rowMeans(x<0.05) # пропорция значимых оклонений n10 n100 n1000 n5000 0.04 0.04 0.20 0.87 Вот р-значения: n10 n100 n1000 n5000 0.760 0.681 0.164 0.007 Из чего следует, что при n=5000, 87% - это вовсе не нормальное распределение, хотя по Q-Q графикам этого не скажешь. К тому же, при больших выборках тесты Стьюдента или ANOVA являются робастными к "ненормальности" данных. 3. Вся идея о нормальности распределения - это лишь математическая аппроксимация, но в реальном мире я не знаю ни одну величину, которая бы на 100% соответсвовала Гауссовскому распределению, но есть величины, которые "достаточно близко" распределены к нормальному. Однако, если мы зараннее знаем, что нет величин, которые бы на 100% соответствовали нормальному распределению, что особенного в том и какую информацию мы получим, если отклоним или не сможем отклонить нулевую гипотезу? 4. И самое главное. Существует очень распространенное заблуждение (особенно в отечественных изданиях) о том, какую информацию предоствляют тесты на нормальность распределения и какой ответ хочет получить исследователь. Тесты на нормальность распределения отвечают на следующий вопрос: "Существует ли достаточно доказательств относительно каких-либо отклонений от Гауссовского распределения?". При достаточно больших выборках ответ будет всегда да! Исследователи же ставят очень часто совершенно иной вопрос: "Мои данные достаточно отклоняются от нормального идеального распределения, чтобы запретить мне использовать тест, который подразумевает Гауссовское распределение?" Это очень похожая ошибка как при трактовке р-значений, а именно: H0|D & D|H0, где Н0 - нулевая гипотеза, D - данные. Исследователи хотят, чтобы тесты на нормальность распределения были неким судьей, который бы решал, в каких случаях использовать ANOVA, а в каких лучше отказаться от дисперсионного анализа и перейти к трансформациям данных, использованию ресамплинга, бутстрепа, непараметрических тестов и т.д. Но тесты на нормальность распределения не были созданы для этих целей. "При р-значении > 0,05 "остаемся" на ANOV'e, при р < 0,05 - идем в непараметрические" - это плохая практика! P.S. Сорри, что так много написал...соскучился за форумом Сообщение отредактировал TheThing - 26.06.2013 - 18:52 |

||

|

|

|

|

27.06.2013 - 18:46 27.06.2013 - 18:46

Сообщение

#3

|

|

|

Группа: Пользователи Сообщений: 1219 Регистрация: 13.01.2008 Из: Челябинск Пользователь №: 4704 |

... 2. По-моему, определять нормальность распеделения с помощью тестов на нормальность распределения при больших выборках не имеет смысла, поскольку даже минимальные отклонения от идеального Гауссовского распределения будут приводить к статистически значимым отличиям. ... 3. Вся идея о нормальности распределения - это лишь математическая аппроксимация, но в реальном мире я не знаю ни одну величину, которая бы на 100% соответсвовала Гауссовскому распределению, но есть величины, которые "достаточно близко" распределены к нормальному. Однако, если мы зараннее знаем, что нет величин, которые бы на 100% соответствовали нормальному распределению, что особенного в том и какую информацию мы получим, если отклоним или не сможем отклонить нулевую гипотезу? ... Исследователи хотят, чтобы тесты на нормальность распределения были неким судьей, который бы решал, в каких случаях использовать ANOVA, а в каких лучше отказаться от дисперсионного анализа и перейти к трансформациям данных, использованию ресамплинга, бутстрепа, непараметрических тестов и т.д. Но тесты на нормальность распределения не были созданы для этих целей. "При р-значении > 0,05 "остаемся" на ANOV'e, при р < 0,05 - идем в непараметрические" - это плохая практика! Всё это так! Но как нам с этим жить?! PS. Прошу прощения за слезу, не сдержался... Сообщение отредактировал nokh - 27.06.2013 - 19:05 |

|

|

|

|

Сообщений в этой теме

Liz Сравнение частот ОДНОГО и ТОГО ЖЕ распределения(?) 24.06.2013 - 14:04

Liz Сравнение частот ОДНОГО и ТОГО ЖЕ распределения(?) 24.06.2013 - 14:04

p2004r Цитата(Liz @ 24.06.2013 - 14:04) Дол... 24.06.2013 - 20:51

p2004r Цитата(Liz @ 24.06.2013 - 14:04) Дол... 24.06.2013 - 20:51

DoctorStat Цитата(Liz @ 24.06.2013 - 15:04) Как... 25.06.2013 - 11:36

DoctorStat Цитата(Liz @ 24.06.2013 - 15:04) Как... 25.06.2013 - 11:36

Liz <p2004r: любым методом детектирующим "выпа... 25.06.2013 - 19:25

Liz <p2004r: любым методом детектирующим "выпа... 25.06.2013 - 19:25

anserovtv Можно применять различные методы. хотя данных у ва... 25.06.2013 - 21:08

anserovtv Можно применять различные методы. хотя данных у ва... 25.06.2013 - 21:08

DoctorStat Цитата(anserovtv @ 25.06.2013 - 22:0... 25.06.2013 - 21:24

DoctorStat Цитата(anserovtv @ 25.06.2013 - 22:0... 25.06.2013 - 21:24

anserovtv Цитата(DoctorStat @ 25.06.2013 - 22... 25.06.2013 - 22:26

anserovtv Цитата(DoctorStat @ 25.06.2013 - 22... 25.06.2013 - 22:26

anserovtv Нормальность по критерию Шапиро-Уилкса также выпо... 25.06.2013 - 21:15

anserovtv Нормальность по критерию Шапиро-Уилкса также выпо... 25.06.2013 - 21:15

nokh t-критерий для сравнения единственного наблюдения ... 25.06.2013 - 23:29

nokh t-критерий для сравнения единственного наблюдения ... 25.06.2013 - 23:29

Liz <anserovtv: Проверяется гипотеза о равенстве ср... 26.06.2013 - 00:14

Liz <anserovtv: Проверяется гипотеза о равенстве ср... 26.06.2013 - 00:14

anserovtv Логичнее все-таки применять одновыборочный критери... 26.06.2013 - 07:46

anserovtv Логичнее все-таки применять одновыборочный критери... 26.06.2013 - 07:46

100$ Цитата(anserovtv @ 26.06.2013 - 07:4... 26.06.2013 - 10:31

100$ Цитата(anserovtv @ 26.06.2013 - 07:4... 26.06.2013 - 10:31

anserovtv Цитата(100$ @ 26.06.2013 - 11:3... 26.06.2013 - 11:44

anserovtv Цитата(100$ @ 26.06.2013 - 11:3... 26.06.2013 - 11:44

100$ Цитата(anserovtv @ 26.06.2013 - 11:4... 26.06.2013 - 12:15

100$ Цитата(anserovtv @ 26.06.2013 - 11:4... 26.06.2013 - 12:15

anserovtv Цитата(100$ @ 26.06.2013 - 13:1... 26.06.2013 - 12:32

anserovtv Цитата(100$ @ 26.06.2013 - 13:1... 26.06.2013 - 12:32

100$ Цитата(anserovtv @ 26.06.2013 - 12:3... 26.06.2013 - 13:04

100$ Цитата(anserovtv @ 26.06.2013 - 12:3... 26.06.2013 - 13:04

DrgLena Цитата(anserovtv @ 26.06.2013 - 07:4... 26.06.2013 - 10:36

DrgLena Цитата(anserovtv @ 26.06.2013 - 07:4... 26.06.2013 - 10:36

DrgLena Student's test

Shapiro-Wilk's test

Пробле... 26.06.2013 - 12:37

DrgLena Student's test

Shapiro-Wilk's test

Пробле... 26.06.2013 - 12:37

100$ Вспоминается (здешняя) форумная баталия, где ряд в... 26.06.2013 - 13:55

100$ Вспоминается (здешняя) форумная баталия, где ряд в... 26.06.2013 - 13:55

TheThing Цитата(nokh @ 27.06.2013 - 18:46) Вс... 27.06.2013 - 19:51

TheThing Цитата(nokh @ 27.06.2013 - 18:46) Вс... 27.06.2013 - 19:51

nokh Цитата(TheThing @ 27.06.2013 - 22:51... 27.06.2013 - 20:22

nokh Цитата(TheThing @ 27.06.2013 - 22:51... 27.06.2013 - 20:22

p2004r откуда вообще уверенность что распределение унимод... 26.06.2013 - 19:49

p2004r откуда вообще уверенность что распределение унимод... 26.06.2013 - 19:49

Liz БОЛЬШОЕ СПАСИБО за подходы по ИСХОДНОМУ вопросу... 26.06.2013 - 23:02

Liz БОЛЬШОЕ СПАСИБО за подходы по ИСХОДНОМУ вопросу... 26.06.2013 - 23:02

100$ Цитата(Liz @ 26.06.2013 - 23:02) БОЛ... 27.06.2013 - 01:01

100$ Цитата(Liz @ 26.06.2013 - 23:02) БОЛ... 27.06.2013 - 01:01

100$ Самое забавное во всей этой истории заключается в ... 28.06.2013 - 12:49

100$ Самое забавное во всей этой истории заключается в ... 28.06.2013 - 12:49

TheThing Цитата(100$ @ 28.06.2013 - 12:4... 28.06.2013 - 13:21

TheThing Цитата(100$ @ 28.06.2013 - 12:4... 28.06.2013 - 13:21

100$ Цитата(TheThing @ 28.06.2013 - 13:21... 28.06.2013 - 14:54

100$ Цитата(TheThing @ 28.06.2013 - 13:21... 28.06.2013 - 14:54

p2004r Цитата(100$ @ 28.06.2013 - 14:5... 28.06.2013 - 21:05

p2004r Цитата(100$ @ 28.06.2013 - 14:5... 28.06.2013 - 21:05

100$ Цитата(p2004r @ 28.06.2013 - 21:05) ... 29.06.2013 - 20:12

100$ Цитата(p2004r @ 28.06.2013 - 21:05) ... 29.06.2013 - 20:12

p2004r Цитата(100$ @ 29.06.2013 - 20:1... 30.06.2013 - 10:12

p2004r Цитата(100$ @ 29.06.2013 - 20:1... 30.06.2013 - 10:12

100$ Цитата1) итак возможность измерить истинную силу с... 30.06.2013 - 13:47

100$ Цитата1) итак возможность измерить истинную силу с... 30.06.2013 - 13:47

p2004r 1) ну конечно ложная корреляция тоже "не позн... 30.06.2013 - 23:40

p2004r 1) ну конечно ложная корреляция тоже "не позн... 30.06.2013 - 23:40

100$ Цитата1) ну конечно ложная корреляция тоже "н... 1.07.2013 - 01:23

100$ Цитата1) ну конечно ложная корреляция тоже "н... 1.07.2013 - 01:23

TheThing Цитата(100$ @ 1.07.2013 - 01:23... 1.07.2013 - 02:48

TheThing Цитата(100$ @ 1.07.2013 - 01:23... 1.07.2013 - 02:48

100$ Цитата(TheThing @ 1.07.2013 - 02:48)... 1.07.2013 - 11:13

100$ Цитата(TheThing @ 1.07.2013 - 02:48)... 1.07.2013 - 11:13

TheThing Цитата(100$ @ 1.07.2013 - 11:13... 1.07.2013 - 16:07

TheThing Цитата(100$ @ 1.07.2013 - 11:13... 1.07.2013 - 16:07

100$ Цитатано я попробую..

Спасибо,TheThing, теперь к ... 1.07.2013 - 20:45

100$ Цитатано я попробую..

Спасибо,TheThing, теперь к ... 1.07.2013 - 20:45

p2004r Вы милейший (тут раз пошли эпитеты значит надо соо... 3.07.2013 - 09:15

p2004r Вы милейший (тут раз пошли эпитеты значит надо соо... 3.07.2013 - 09:15

Liz Вариант г) тоже не является правильным ответом... 1.07.2013 - 22:42

Liz Вариант г) тоже не является правильным ответом... 1.07.2013 - 22:42

100$ Ба! Какие люди! Топикстартер собственной п... 2.07.2013 - 00:10

100$ Ба! Какие люди! Топикстартер собственной п... 2.07.2013 - 00:10

p2004r вас ткнули носом в вашу же "промашку" пр... 3.07.2013 - 09:25

p2004r вас ткнули носом в вашу же "промашку" пр... 3.07.2013 - 09:25

100$ Как там у Дюма: "Д'Артаньян был не так гл... 3.07.2013 - 16:19

100$ Как там у Дюма: "Д'Артаньян был не так гл... 3.07.2013 - 16:19

p2004r Цитата(100$ @ 3.07.2013 - 16:19... 3.07.2013 - 18:02

p2004r Цитата(100$ @ 3.07.2013 - 16:19... 3.07.2013 - 18:02

Liz <nokh: t-критерий для сравнения единственного н... 4.07.2013 - 17:30

Liz <nokh: t-критерий для сравнения единственного н... 4.07.2013 - 17:30

nokh Цитата(Liz @ 4.07.2013 - 20:30) ... 4.07.2013 - 19:14

nokh Цитата(Liz @ 4.07.2013 - 20:30) ... 4.07.2013 - 19:14  |