Здравствуйте, гость ( Вход | Регистрация )

25.05.2022 - 12:45 25.05.2022 - 12:45

Сообщение

#1

|

|

|

Группа: Пользователи Сообщений: 27 Регистрация: 7.12.2012 Пользователь №: 24440 |

Салют! Столкнулся с проблемой сравнения двух выборок, в каждой из которых по 3 значения. Это результаты иммуноблоттинга (определение концентрации целевого белка в пробе) очень ценных образцов, полученных от трансгенных животных. Но их - образцов, было всего 3 для каждой из групп (2 группы: интактная и подвергнутая воздействию исследуемого фактора). Покопавшись в литературе, нашёл статьи, где есть такие выборки и авторы как ни в чём не бывало используют t-критерий Стьюдента для сравнения средних. Нашёл статьи, где используют U-критерий Манна-Уитни... Скажем так, в биологии 3 образца - это нормально для публикации, если речь идёт об особо ценном и сложнополучаемом биоматериале (к примеру как у меня, когда животные практически не дают потомства). Т.е. представить эти данные можно и не стыдно. Но вот как сравнить, как показать, что эти выборки отличаются статистически значимо, иными словами, что наш исследуемый фактор значимо повлиял на концентрацию целевого белка?

Почитал ещё о таком методе, как ресамплинг или бутстреп, когда объём выборки искусственно увеличивают. Ну, не знаю насколько это правильно... также не нашёл софт и чёткого понимания как это сделать у меня нет. Работаю в проге Statistica 12 Посоветуйте, как всё же обработать эти данные. Вот пример исходных цифр: Выборка 1: 221,60112 305,217725 295,251684 Выборка 2: 371,3313 397,452722 437,212724 |

|

|

|

|

|

Ответов

23.06.2022 - 04:56 23.06.2022 - 04:56

Сообщение

#2

|

|

|

Группа: Пользователи Сообщений: 262 Регистрация: 1.06.2022 Из: Донецк Пользователь №: 39632 |

Этот ответ справедлив только для критериев рандомизации. Но ими арсенал прикладной статистики не ограничивается.

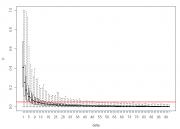

n1=1 - вполне себе встречающийся на практике случай, но только если n2>1. Чисто теоретически, в сфероконном случае статистика начинается с n1=1 b n2=2 (что б было, где дисперсию считать). Стало интересно, как в таких условиях себя покажет критерий Стьюдента при выполнении всех допущений (в том числе о равенстве дисперсий, поскольку даже чисто теоретически тут различия в дисперсиях оценить невозможно). К сожалению функция power.t.test() работает только с одинаковыми n. Но можно помоделировать красивее: Код d<-1 p<-replicate(1000, t.test(rnorm(2, 0, 1), rnorm(1, d, 1),var.eq=T)$p.value) delta<-rep(d, 1000) res<-data.frame(delta, p) mean_p1<-mean(p) mean_p<-rep(NA, 99) for (i in 1:99) { d<-d+1 p<-replicate(1000, t.test(rnorm(2, 0, 1), rnorm(1, d, 1),var.eq=T)$p.value) mean_p[i]<-mean(p) delta<-rep(d, 1000) res_<-data.frame(delta, p) res<-rbind(res, res_) } boxplot(p~delta, data=res, range=0) abline(0.05,0, lwd=2, col="red") Вывод: после величины эффекта, равной 12 сигмам, нулевая гипотеза вероятнее будет отклонена на пятипроцентном уровне значимости, чем принята. А после разницы в 18 сигм критерий работает уже достаточно уверенно. Увы с однопроцентным уровнем сильно хуже: можете нарисовать abline(0.01, 0) и поплакать над ней. Сообщение отредактировал ИНО - 23.06.2022 - 04:57 |

|

|

|

|

Сообщений в этой теме

Vitek_22 Критерий для анализа сверхмалых выборок 25.05.2022 - 12:45

Vitek_22 Критерий для анализа сверхмалых выборок 25.05.2022 - 12:45

Игорь В принципе любая непараметрика. Можно посмотреть к... 26.05.2022 - 08:42

Игорь В принципе любая непараметрика. Можно посмотреть к... 26.05.2022 - 08:42

salm Цитата(Игорь @ 26.05.2022 - 08:42) В... 24.02.2023 - 13:32

salm Цитата(Игорь @ 26.05.2022 - 08:42) В... 24.02.2023 - 13:32

ИНО В указанных критериях объемы выборок, учитывается ... 24.02.2023 - 14:47

ИНО В указанных критериях объемы выборок, учитывается ... 24.02.2023 - 14:47

salm Цитата(ИНО @ 24.02.2023 - 14:47) В у... 24.02.2023 - 20:55

salm Цитата(ИНО @ 24.02.2023 - 14:47) В у... 24.02.2023 - 20:55

100$ > Спасибо. А в принципе, такое выражение ... 24.02.2023 - 23:32

100$ > Спасибо. А в принципе, такое выражение ... 24.02.2023 - 23:32

Игорь Цитата(salm @ 24.02.2023 - 14:32) Зд... 24.02.2023 - 17:37

Игорь Цитата(salm @ 24.02.2023 - 14:32) Зд... 24.02.2023 - 17:37

salm Цитата(Игорь @ 24.02.2023 - 17:37) Е... 24.02.2023 - 20:47

salm Цитата(Игорь @ 24.02.2023 - 17:37) Е... 24.02.2023 - 20:47

ИНО Цитата(salm @ 24.02.2023 - 20:47) А ... 25.02.2023 - 05:37

ИНО Цитата(salm @ 24.02.2023 - 20:47) А ... 25.02.2023 - 05:37

Игорь Цитата(ИНО @ 25.02.2023 - 05:37) Кон... 1.03.2023 - 10:25

Игорь Цитата(ИНО @ 25.02.2023 - 05:37) Кон... 1.03.2023 - 10:25

Vitek_22 Игорь, спасибо. А как обосновать использование это... 26.05.2022 - 10:41

Vitek_22 Игорь, спасибо. А как обосновать использование это... 26.05.2022 - 10:41

100$ Цитата(Vitek_22 @ 26.05.2022 - 10:41... 26.05.2022 - 17:46

100$ Цитата(Vitek_22 @ 26.05.2022 - 10:41... 26.05.2022 - 17:46

Игорь Цитата(Vitek_22 @ 26.05.2022 - 10:41... 31.05.2022 - 07:07

Игорь Цитата(Vitek_22 @ 26.05.2022 - 10:41... 31.05.2022 - 07:07

ИНО Вот-только при помощи перестановок Вы никогда не д... 5.06.2022 - 23:55

ИНО Вот-только при помощи перестановок Вы никогда не д... 5.06.2022 - 23:55

Игорь Цитата(Vitek_22 @ 25.05.2022 - 13:45... 9.06.2022 - 13:53

Игорь Цитата(Vitek_22 @ 25.05.2022 - 13:45... 9.06.2022 - 13:53

100$ Цитата(Игорь @ 9.06.2022 - 13:53) Кр... 9.06.2022 - 16:17

100$ Цитата(Игорь @ 9.06.2022 - 13:53) Кр... 9.06.2022 - 16:17

ИНО Цитата(100$ @ 9.06.2022 - 16:17... 9.06.2022 - 23:21

ИНО Цитата(100$ @ 9.06.2022 - 16:17... 9.06.2022 - 23:21

100$ Цитата(ИНО @ 9.06.2022 - 23:21) Поче... 10.06.2022 - 10:08

100$ Цитата(ИНО @ 9.06.2022 - 23:21) Поче... 10.06.2022 - 10:08

ИНО Сдается мне, Ваше творение нагло врет, по крайней ... 9.06.2022 - 16:05

ИНО Сдается мне, Ваше творение нагло врет, по крайней ... 9.06.2022 - 16:05

Игорь Спасибо коллегам за подробный разбор. Проверил. Сн... 9.06.2022 - 20:08

Игорь Спасибо коллегам за подробный разбор. Проверил. Сн... 9.06.2022 - 20:08

ИНО ЦитатаГрубо говоря - одно и то же. Исправлять нече... 9.06.2022 - 22:28

ИНО ЦитатаГрубо говоря - одно и то же. Исправлять нече... 9.06.2022 - 22:28

Игорь Цитата(ИНО @ 9.06.2022 - 22:28) Одна... 10.06.2022 - 13:15

Игорь Цитата(ИНО @ 9.06.2022 - 22:28) Одна... 10.06.2022 - 13:15

ИНО Очевидно, сии подделки экселя прозрачно намекают, ... 10.06.2022 - 14:00

ИНО Очевидно, сии подделки экселя прозрачно намекают, ... 10.06.2022 - 14:00

ИНО Почитал мануал ПАСТа, относительно "permutati... 11.06.2022 - 15:09

ИНО Почитал мануал ПАСТа, относительно "permutati... 11.06.2022 - 15:09

100$ Цитата(ИНО @ 11.06.2022 - 15:09) Пол... 12.06.2022 - 12:43

100$ Цитата(ИНО @ 11.06.2022 - 15:09) Пол... 12.06.2022 - 12:43

ИНО ЦитатаА это разовое значение (в смысле, полученное... 13.06.2022 - 19:29

ИНО ЦитатаА это разовое значение (в смысле, полученное... 13.06.2022 - 19:29

nokh Цитата(Vitek_22 @ 25.05.2022 - 14:45... 17.06.2022 - 07:34

nokh Цитата(Vitek_22 @ 25.05.2022 - 14:45... 17.06.2022 - 07:34

ИНО Цитата(nokh @ 17.06.2022 - 07:34) Мо... 17.06.2022 - 13:17

ИНО Цитата(nokh @ 17.06.2022 - 07:34) Мо... 17.06.2022 - 13:17

100$ Цитата(ИНО @ 17.06.2022 - 13:17) ...... 17.06.2022 - 13:26

100$ Цитата(ИНО @ 17.06.2022 - 13:17) ...... 17.06.2022 - 13:26

100$ ЦитатаНе знаю почему уважаемые участники форума не... 17.06.2022 - 12:13

100$ ЦитатаНе знаю почему уважаемые участники форума не... 17.06.2022 - 12:13

ИНО Хороший вопрос! Документация пакета boot (свер... 17.06.2022 - 17:12

ИНО Хороший вопрос! Документация пакета boot (свер... 17.06.2022 - 17:12

100$ Цитата(ИНО @ 17.06.2022 - 17:12) Выв... 18.06.2022 - 01:12

100$ Цитата(ИНО @ 17.06.2022 - 17:12) Выв... 18.06.2022 - 01:12

ИНО Ну что поделать, я не умею толком ни программирова... 18.06.2022 - 01:54

ИНО Ну что поделать, я не умею толком ни программирова... 18.06.2022 - 01:54

comisora Добрый день.

Предлагаю рассмотреть на жизнеспособн... 18.06.2022 - 17:49

comisora Добрый день.

Предлагаю рассмотреть на жизнеспособн... 18.06.2022 - 17:49

ИНО ИМХО бета тут как бы совсем за уши притянута, огра... 18.06.2022 - 18:17

ИНО ИМХО бета тут как бы совсем за уши притянута, огра... 18.06.2022 - 18:17

comisora 2ИНО

Ошибки исправил, результат тоже, спасибо.

По... 18.06.2022 - 19:12

comisora 2ИНО

Ошибки исправил, результат тоже, спасибо.

По... 18.06.2022 - 19:12

100$ >comisora,

а вы можете откомментировать констр... 18.06.2022 - 21:26

100$ >comisora,

а вы можете откомментировать констр... 18.06.2022 - 21:26

comisora 2 100$

Конечно. Это я усложнил код, так как ... 18.06.2022 - 23:53

comisora 2 100$

Конечно. Это я усложнил код, так как ... 18.06.2022 - 23:53

100$ Цитата(comisora @ 18.06.2022 - 23:53... 19.06.2022 - 00:16

100$ Цитата(comisora @ 18.06.2022 - 23:53... 19.06.2022 - 00:16

100$ Подведем некоторые промежуточные итоги.

В соответ... 19.06.2022 - 22:20

100$ Подведем некоторые промежуточные итоги.

В соответ... 19.06.2022 - 22:20

comisora 2 100$

У меня опыта создания пакетов нет (да... 20.06.2022 - 00:42

comisora 2 100$

У меня опыта создания пакетов нет (да... 20.06.2022 - 00:42

ИНО Цитата(100$ @ 19.06.2022 - 22:2... 20.06.2022 - 04:56

ИНО Цитата(100$ @ 19.06.2022 - 22:2... 20.06.2022 - 04:56

100$ "Я проснулся сегодня рано..." (Исполняет... 20.06.2022 - 13:01

100$ "Я проснулся сегодня рано..." (Исполняет... 20.06.2022 - 13:01

ИНО Нет, на той гистограмме - распределение при нулево... 20.06.2022 - 17:10

ИНО Нет, на той гистограмме - распределение при нулево... 20.06.2022 - 17:10

100$ ЦитатаНет, на той гистограмме - распределение при ... 20.06.2022 - 23:24

100$ ЦитатаНет, на той гистограмме - распределение при ... 20.06.2022 - 23:24

ИНО Да все в порядке изначально было с гистограммой ст... 21.06.2022 - 03:31

ИНО Да все в порядке изначально было с гистограммой ст... 21.06.2022 - 03:31

100$ ЦитатаС этим не спорю. Заметьте, здесь порядок циф... 21.06.2022 - 12:21

100$ ЦитатаС этим не спорю. Заметьте, здесь порядок циф... 21.06.2022 - 12:21

ИНО Ну, результаты моделирования как бы намекают, что ... 21.06.2022 - 21:00

ИНО Ну, результаты моделирования как бы намекают, что ... 21.06.2022 - 21:00

100$ Цитата(ИНО @ 21.06.2022 - 21:00) А в... 23.06.2022 - 00:19

100$ Цитата(ИНО @ 21.06.2022 - 21:00) А в... 23.06.2022 - 00:19

comisora Цитата(100$ @ 21.06.2022 - 12:2... 22.06.2022 - 10:42

comisora Цитата(100$ @ 21.06.2022 - 12:2... 22.06.2022 - 10:42

100$ Но, если уж на то пошло, для желаемого соотношения... 23.06.2022 - 11:10

100$ Но, если уж на то пошло, для желаемого соотношения... 23.06.2022 - 11:10

salm Добрый день. пожалуйста, у меня есть парные измер... 12.01.2023 - 11:51

salm Добрый день. пожалуйста, у меня есть парные измер... 12.01.2023 - 11:51

100$ Цитата(salm @ 12.01.2023 - 11:51) До... 12.01.2023 - 13:39

100$ Цитата(salm @ 12.01.2023 - 11:51) До... 12.01.2023 - 13:39

salm Цитата(100$ @ 12.01.2023 - 13:3... 12.01.2023 - 16:09

salm Цитата(100$ @ 12.01.2023 - 13:3... 12.01.2023 - 16:09

ИНО Проблема множественных сравнений отнюдь не исчерпы... 1.03.2023 - 12:35

ИНО Проблема множественных сравнений отнюдь не исчерпы... 1.03.2023 - 12:35

Игорь Цитата(ИНО @ 1.03.2023 - 12:35) Проб... 1.03.2023 - 20:24

Игорь Цитата(ИНО @ 1.03.2023 - 12:35) Проб... 1.03.2023 - 20:24

ИНО Пример 1. Почему у Смирнова мощность значительно м... 2.03.2023 - 07:16

ИНО Пример 1. Почему у Смирнова мощность значительно м... 2.03.2023 - 07:16

Игорь Цитата(ИНО @ 2.03.2023 - 08:16) А ве... 2.03.2023 - 07:39

Игорь Цитата(ИНО @ 2.03.2023 - 08:16) А ве... 2.03.2023 - 07:39

ИНО Так-то оно так, вот только для перестраховки приня... 2.03.2023 - 10:06

ИНО Так-то оно так, вот только для перестраховки приня... 2.03.2023 - 10:06

Игорь Цитата(ИНО @ 2.03.2023 - 10:06) Так-... 2.03.2023 - 11:10

Игорь Цитата(ИНО @ 2.03.2023 - 10:06) Так-... 2.03.2023 - 11:10

ИНО Причем тут смежные области? Вопрос лежит сугубо в ... 2.03.2023 - 11:51

ИНО Причем тут смежные области? Вопрос лежит сугубо в ... 2.03.2023 - 11:51  |